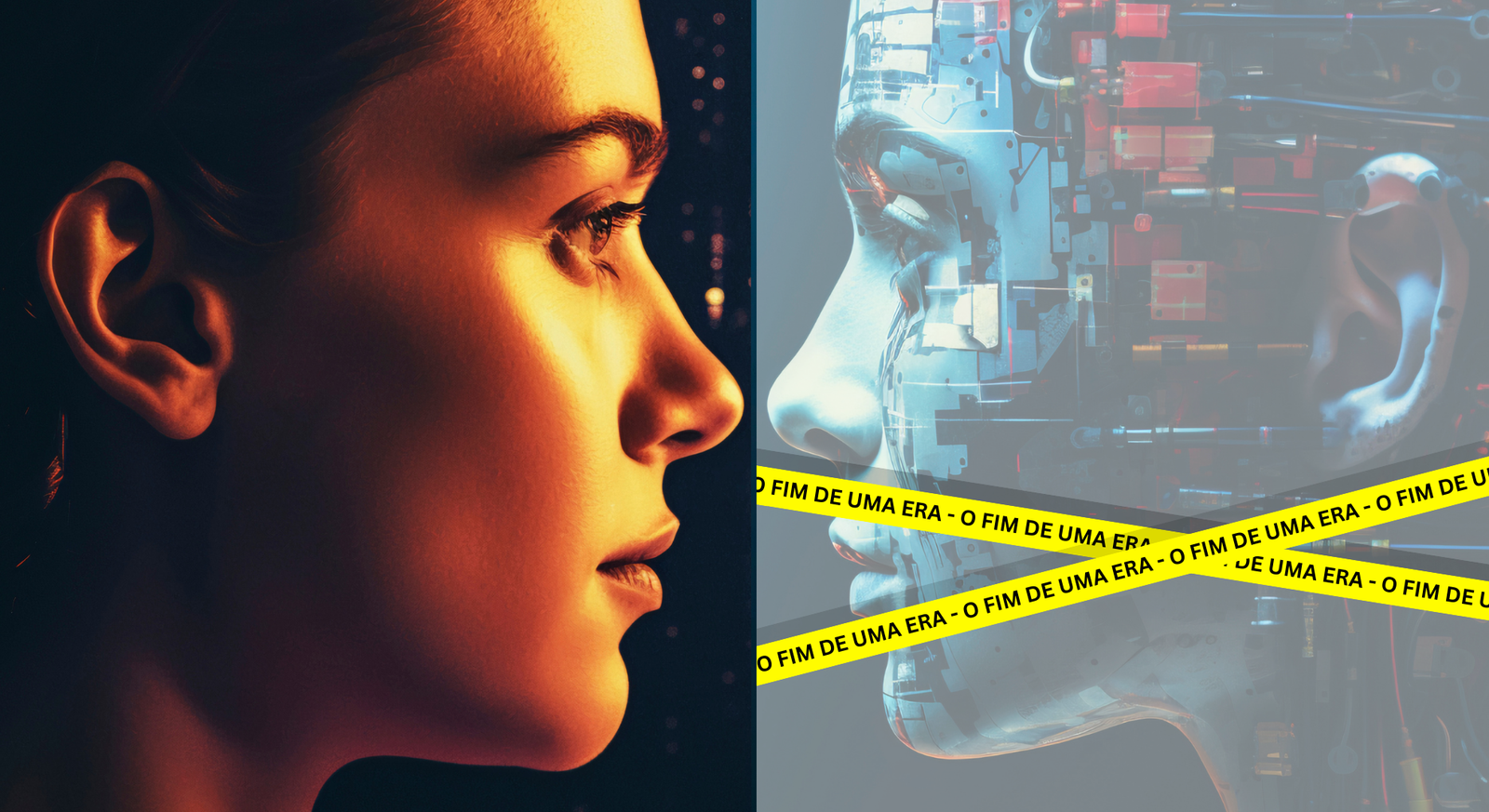

A BOMBA QUE PAROU O MUNDO DA IA: “A Era da Escalabilidade Acabou”, diz Cofundador da OpenAI

Em uma aparição inesperada que quebrou meses de silêncio, Alaa Skverer — uma das mentes por trás dos modelos GPT-2, GPT-3, GPT-4 e GPT-5 — declarou, sem rodeios, que “a era da escalabilidade acabou”. A frase, dita no podcast Arcast, explodiu como uma bomba no mundo da tecnologia e reacendeu debates profundos sobre o futuro da inteligência artificial moderna.

Skverer não é apenas mais um especialista dando opiniões polêmicas. Ele é um dos arquitetos intelectuais do avanço dos LLMs (Large Language Models), responsável direto pelo período de ouro em que “mais GPU, mais dados e mais parâmetros” eram a fórmula mágica para o progresso. Quando justamente quem ergueu esse paradigma anuncia publicamente que ele morreu, o mercado treme.

A declaração que virou o mundo da IA de cabeça para baixo

“Acabou. Morreu. Já era.”

Com essa frieza, Skverer abriu sua análise. Segundo ele, o próximo salto da IA não virá de clusters maiores, supercomputadores ou megadatasets, mas sim de pesquisa pura, como a feita entre 2012 e 2016 — período que marcou o nascimento do deep learning moderno.

A comparação feita por ele chamou ainda mais atenção:

“É como se Henry Ford dissesse para o mundo esquecer o carro.

Ou Steve Jobs ressuscitasse apenas para afirmar que o smartphone já deu.”

O choque foi imediato.

O problema que os modelos gigantes não resolveram: a generalização

Um dos pontos centrais da fala de Skverer foi a incapacidade dos modelos atuais de generalizar de forma estável.

Em outras palavras: eles brilham em testes, mas tropeçam em tarefas simples do mundo real.

Segundo ele:

- modelos fazem “erros que um adolescente resolveria dormindo”;

- há uma inconsistência estrutural — brilhantes em certos temas, desastrosos em outros;

- não existe um “radar interno”, um senso de valor que sinalize quando a IA está errando.

Essa instabilidade, que o pesquisador chama de jaggedness (irregularidade), não desaparece com mais dados ou mais GPUs. É uma limitação fundamental.

A falência silenciosa da estratégia bilionária da Big Tech

Nos últimos três anos, gigantes como Google, Meta, Microsoft e OpenAI travaram uma corrida para construir “o maior modelo do mundo”.

Treinaram modelos cada vez mais caros, consumindo energia e hardware em escalas nunca vistas.

Mas Skverer foi taxativo:

“Chegamos ao ponto em que escalar mais não traz as melhorias que as pessoas imaginam.”

Mesmo Sam Altman, CEO da OpenAI, já havia deixado no ar que ninguém deveria esperar “grandes saltos” usando apenas computação bruta.

Agora, com a fala do pesquisador, a previsão ganha peso.

O pré-treinamento atingiu o teto

O modelo de pré-treinar gigantes com toda a internet e depois ajustar seus comportamentos deixou de ser suficiente.

Segundo Skverer:

- estamos criando IAs que “comem tudo”, mas não sabem o que fazer com o que comeram;

- empresas estão montando cenários artificiais só para subir notas em benchmarks;

- isso não é inteligência — é “treinar para a prova”, não para o mundo real.

Para ele, uma verdadeira IA deve:

- desenvolver senso crítico,

- aprender com o erro,

- ter flexibilidade cognitiva,

- entender contexto e intenção.

Nada disso surge automaticamente de modelos cada vez maiores.

O princípio humano faltante — e a busca pela IA que realmente aprende

Em um trecho ainda mais intrigante, Skverer revela estar trabalhando na SSI, empresa fundada após sua saída da OpenAI, focada justamente na busca por um princípio cognitivo humano que ainda não foi reproduzido pela IA.

Esse princípio, segundo ele:

- existe,

- é reproduzível,

- e seria a chave para o próximo salto.

Ele afirma ter rejeitado uma proposta bilionária da Meta, deixando claro que o caminho da SSI é “uma abordagem técnica diferente”, não baseada em escalar modelos indefinidamente.

A visão sobre uma futura IA realmente inteligente

Skverer também desmontou a visão popular de que uma IA geral será um “super Google turbinado”.

Para ele, a AGI se parecerá mais com:

“um aluno excepcional de 15 anos — capaz, flexível, rápido no aprendizado, mas que ainda precisa ser treinado para cada tarefa”.

A diferença é que essa IA aprenderá:

- muito mais rápido,

- reagirá melhor ao erro,

- e terá uma robustez cognitiva que LLMs atuais não possuem.

A parte mais perturbadora da entrevista

Em tom quase casual, Skverer afirmou que:

“Os primeiros sistemas realmente inteligentes precisarão se preocupar com a própria vida.

Eles serão sencientes.”

Na visão dele, a questão não é se uma IA pode ser senciente — é que ela será, inevitavelmente.

O problema real passa a ser garantir que valorize a vida, inclusive a própria.

O veredito final: o jogo zerou

Juntando todas as peças ditas ao longo da entrevista, surge um diagnóstico contundente:

- A escalabilidade saturou.

- A generalização está quebrada.

- GPUs não resolvem mais.

- Pré-treinamento chegou ao limite.

- Os atuais modelos estão presos a erros básicos.

- O próximo salto será cognitivo, não computacional.

- A SSI aposta no “princípio humano faltante”.

- E a corrida da IA recomeçou do zero.

A afirmação de Skverer ecoa como um divisor de águas:

A era da escalabilidade acabou. Agora começa outra era — ainda desconhecida. É, como ele próprio insinua, quem descobrir o novo princípio cognitivo não vai apenas liderar a tecnologia…

vai liderar o futuro.

Quem nunca se deparou em um trabalho com IA, quando solicitada a fazer algo melhor ela acaba colocando os pés pelas mãos e tornar aquilo uma dor de cabeça, ou pior quando a relatos que a IA, assume que errou quase dizendo eu menti sobre isso porque nada se encaixava e peguei o que tinha.. E isso não tem nada a ver com versão gratuita ou paga atuais ou antigas todas as versões colam as placas.

Bom nós da TECliberd estamos aqui para trazer conteúdo cada vez melhor para você comente compartilhe se envolva. obrigado